A partir du 1er septembre 2019, Google abandonnera définitivement la prise en compte de la directive Noindex dans le fichier robots.txt dans le but de standardiser de manière officielle son protocole d’interprétation, développé il y a 25 ans par Martijn Koster.

Bien que cette consigne n’ait jamais été validée officiellement par le moteur de recherche, elle restait efficace pour permettre aux webmasters de désindexer les urls en masse notamment dans le cas où la gestion par meta robots était compliquée.

Comme on peut le lire dans le communiqué officiel de Google :

« Les moteurs de recherche ne peuvent indexer que les pages qu’ils connaissent, donc bloquer la page pour éviter qu’elle ne soit explorée signifie généralement que son contenu ne sera pas indexé. Bien que le moteur de recherche puisse également indexer une URL à partir de liens d’autres pages, sans voir le contenu lui-même, nous visons à rendre ces pages moins visibles à l’avenir ».

Par ailleurs, Google précise que le robots.txt est destiné à la gestion du crawl des robots et non pas à l’indexation.

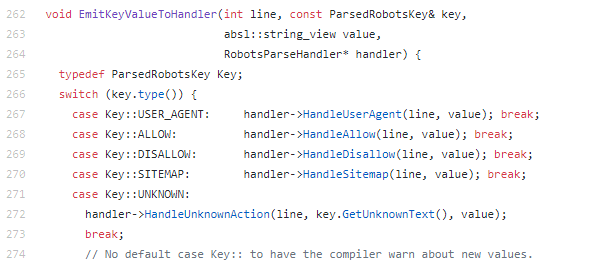

En parallèle, Google a open-sourcé sur Github son interpréteur de règles pour tester n’importe quel fichier robots.txt.

Fin du Noindex dans le robots.txt : Quels impacts ?

Tout cela signifie que les sites qui utilisaient le Noindex dans leur robots.txt devront revoir leur façon de gérer l’indexation (meta robots ou X-Robots-Tag noindex, 404/410, etc).

Dans le cas où le Noindex: (blocage de l’indexation) serait couplé systématiquement avec un Disallow: (blocage du crawl), ce changement n’aura que peu d’impact. Pour rester en alerte suite à ce changement, il est toujours possible de suivre l’évolution du nombre de pages marquées comme « Indexée malgré le blocage par le fichier robots.txt » dans la Google Search Console.

Ce changement s’accompagne aussi à d’autres évolutions majeures, comme l’utilisation maintenant possible du robots.txt pour tous les protocoles (ftp par exemple) et la mise en cache du fichier dont les règles continueront d’être appliquées même si le site est indisponible.

Nous ne manquerons pas de vous tenir informés de l’évolution de la situation.