Pour beaucoup de SEO, ce n’est pas la nouvelle itération de Penguin qui va prochainement poser problème, mais plutôt le déploiement imminent du Knowledge Graph dans les résultats. Vous savez, ces éléments d’informations qui enrichissent la colonne de droite, là où l’on avait l’habitude de voir uniquement des annonces Adwords. L’année dernière, juste avant le déploiement de Google+, Google a annoncé que dans certains cas, les Adwords pourraient apparaitre en bas de page. Avec le recul, on se rend compte que Google faisait en fait de la place à G+ et au Knowledge Graph…

Pour l’instant, sur google.fr vous ne verrez apparaitre des boites à cet emplacement que sur certaines requêtes correspondant à des lieux géographiques / touristiques, avec un mix entre du Google Adresses, des images, et des avis. Il ne s’agit pas réellement du Knowledge Graph (KG), mais plutot d’une mise en avant de Google+ Local.

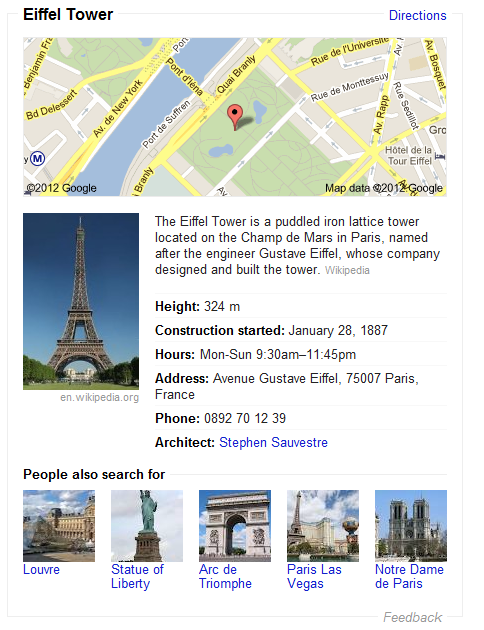

Lorsque le KG sera déployé, ces box seront enrichies avec des données structurées, comme cela est déjà le cas sur google.com :

De même, à cet emplacement on trouve parfois un bloc Google+, par exemple sur la requête Cdiscount.

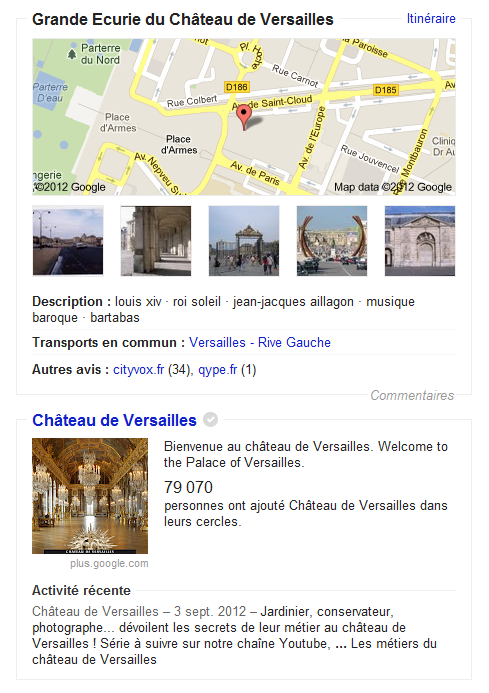

Parfois encore, on trouvera un bloc G+ Local et un bloc Google+ sur une même requête. Exemple sur la requête « chateau de versailles« .

Pour rappel, ce que Google nomme le « Knowledge Graph » correspond à la présentation de données organisées autour d’un concept, une entité nommée, avec pour objectif affiché d’apporter directement la réponse à la question de l’internaute. En réalité, les objectifs de Google sont sans doute plus larges que cela :

- retenir l’internaute plus longtemps sur ses pages

- renforcer sa stratégie actuelle, qui consiste à se positionner en tant qu’éditeur de contenus, afin notamment de lutter contre Facebook

- …

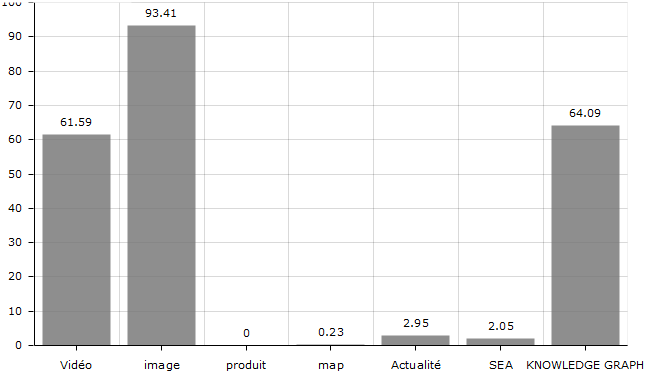

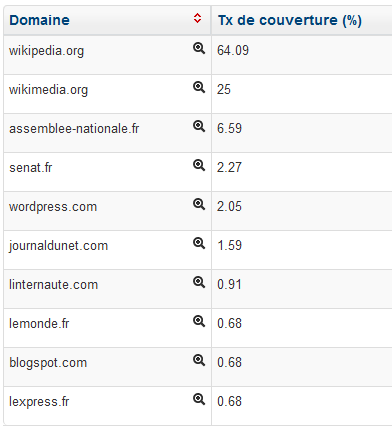

Etude sur le champs lexical People – Google.com

Nous avons mis sous surveillance une liste de 400 personnalités connues en France afin de requêter tous les jours Google.fr pour être au courant le jour où Google KG sera déployé. En requêtant la liste sur Google.com, nous avons déjà une idée de l’impact que cela va avoir et des sites qui vont en profiter : sur cette liste orientée « people », on peut voir que 64% des mots clés déclenchent un bloc KG. C’est pas aussi bien que Google Images (93%), mais c’est mieux que Vidéos (61%)

Ensuite, les sites qui sont le plus fréquemment listés dans ces boites KG sont les suivants :

Wikipedia domine largement mais laisse quelques miettes à d’autres sites, qui remontent principalement via leurs images affichées par Google.

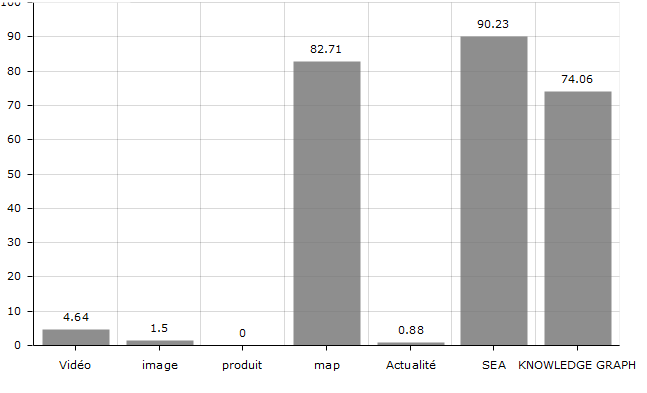

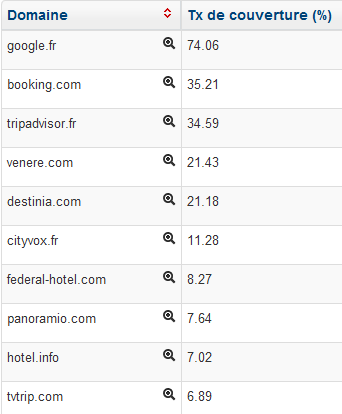

Etude sur 800 noms d’hotels parisiens – Google.fr

En parallèle, nous pouvons présager de l’impact que pourra avoir le Knowledge Graph sur le secteur du voyage, avec l’étude d’une liste de 800 noms d’hôtels parisiens requêtés sur Google.fr

Nous passons ici à 74% de blocs KG déclenchés (rappelons qu’il s’agit pour l’instant de bloc G+ Local), avec une meilleure répartition sur les sites leaders. Les bénéficiaires sont des sites qui présentent un grand nombre d’avis de consommateurs.

Les types de requêtes touchées

Ces deux études ont été faites sur un échantillon non représentatif de mots clés et sur des thématiques limitées. Il faut garder en tête que le Knowledge Graph va toucher ce que Google Appelle les « Named Entity Queries » qui sont de plusieurs sortes :

- People : célébrités, figures publiques, personnes ordinaires…

- Lieux géographiques : pays, régions, départements, villes, quartiers…

- Lieux célèbres : monuments, attractions touristiques, merveilles du monde…

- Entreprises, produits et noms de marque : Orange, iPad, Renault Scenic…

- Organisations et institutions : les Nations Unies, le FMI, la Sorbonne, le PSG :)…

- Oeuvres artistiques : livres, spectacles, films, pieces musicales, tableaux etc.

- Evenements : Jeux Olympiques, marathon de Paris, le tirage de l’Euromillion, etc.

Google exploite pour cela Freebase, racheté en juillet 2010. Il s’agit d’une base de données d’environ 22 millions d’entités nommées, que Google a développée pour atteindre aujourd’hui plusieurs centaines de millions de lignes.

Qu’est-ce que cela présage pour les éditeurs ?

Il y a fort à parier que les possibilités d’actions SEO pour augmenter sa visibilité au sein du Knowledge Graph seront limitées à quelques optimisations liées à Google Images, Maps ou de structuration des données affichées. Au final, Google sélectionne le type de sites qui auront la chance de bénéficier de ce nouveau format de résultats. Il y aura sans doute quelques trucs et astuces comme le hotlinking d’images sur des sites trustées, mais pas grand chose de plus à se mettre sous la dent. L’importance de Google News risque aussi d’être renforcée car beaucoup d’internautes qui recherchent une entité veulent de l’actualité.

Par ailleurs, certaines utilisations des contenus récupérés sur les sites crawlés paraissent étonnantes : sur le mot clé « jean-jacques urvoas« , sur google.com, c’est une image tirée de lexpress.fr qui s’affiche, mais l’internaute est renvoyé sur le site du Parti Socialiste.

Ainsi, Google se positionne de plus en plus comme éditeur et réceptacle à contenus. Si l’objectif est de devenir un portail aussi addictif que Facebook, il faut pouvoir présenter aux internautes du contenu et pas uniquement des liens sortants. Les récentes évolutions et acquisitions montrent que c’est désormais le sens de la marche pour Google :

- promotion à outrance de G+, considéré en interne comme un upgrade complet de Google, et avec lequel il devient un repository à contenus, comme FB ou Twitter, et non plus un simple agrégateur ;

- lancement de Google Play cette année, avec la diffusion de Vidéos / Livres électroniques ;

- rachat des guides de voyages Frommer’s cet été

- lancement de sa plateforme de gestion de commentaires intégrée à Google+

- etc. il ne s’agit là que de quelques exemples..

La question que l’on peut se poser est la suivante : puisque Google s’oriente de plus en plus vers la rétention des internautes, sur un mode « portail », quel sera l’intérêt à terme pour les sites éditeurs de laisser Google exploiter ses contenus afin d’enrichir ce type de blocs ? La réponse pourrait être la suivante : tant que Google continue à envoyer du trafic chez ces éditeurs, ces derniers laisseront Googlebot accéder à leurs pages. Google devra donc y aller doucement pour éviter une fronde de certains éditeurs qui pourraient alors interdire l’indexation de leurs contenus. Nous pensons notamment à certains services de météo, résultats sportifs, horaires de cinéma, ou autres sites qui perdent un peu plus de trafic à chaque enrichissement des résultats Google.

C’est certes un vieux débat un peu polémique, mais la question se pose tout de même, qu’en pensez-vous ?