Durant le SMX Paris 2012, je suis intervenu avec Marie Pourreyron au sujet des outils SEO.

Vous trouverez ci-dessous les principaux outils que j’ai présenté, et prochainement sur le site de Marie un récapitulatif de sa venue au SMX, qui ravira notamment les possesseurs de Mac et dans lequel vous trouverez quelques perles, comme Oscaar ou Ghostery pour ne citer qu’eux.

La plupart de ces outils offrent une partie gratuite, ou disposent d’une version d’essai

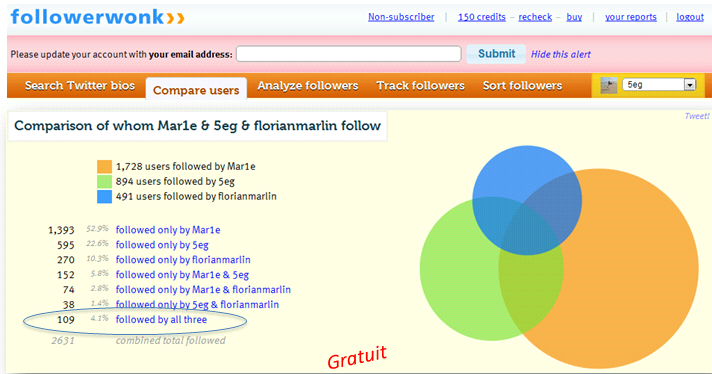

Followerwonk.com : pour trouver rapidement les bon twittos sur un secteur

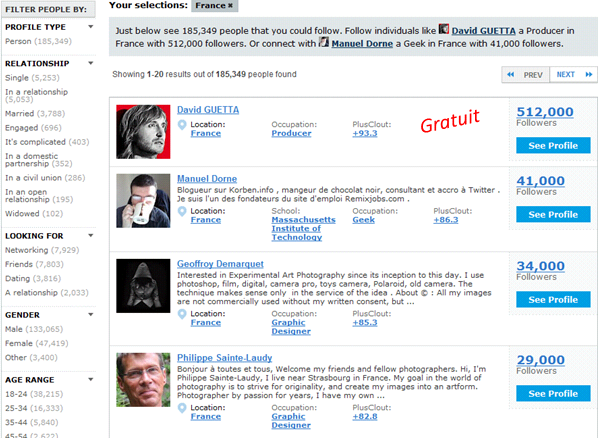

FindPeolpleOnPlus, l’équivalent de Followerwonk, mais pour Google+. Plus de 180 000 comptes FR listés

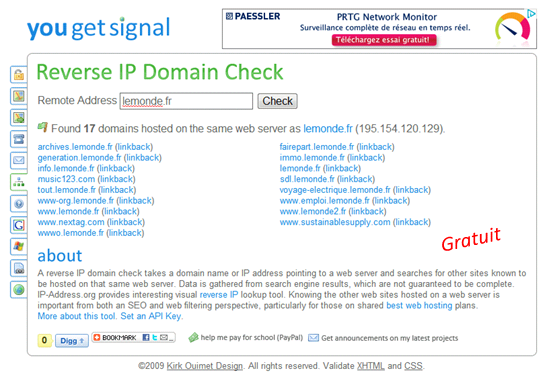

You get signal : pour faire un reverse IP et trouver tous les domaines hébergés sur un serveur, entre autres

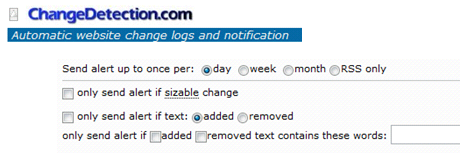

ChangeDetection : pour surveiller une page d’un site concurrent, ou la page d’un partenaire qui contient notre lien… et être alerté par mail en cas de changement.

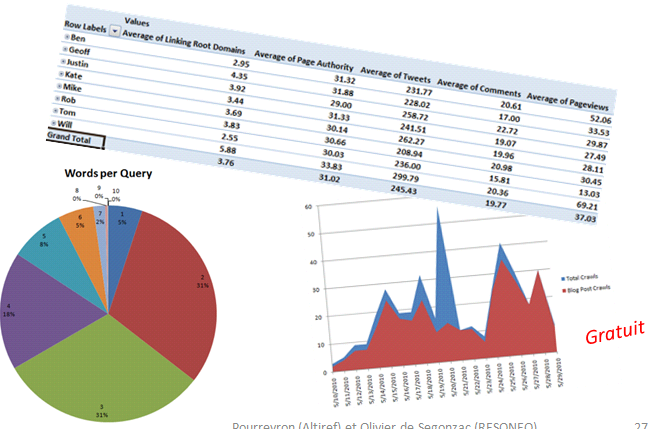

Excel for SEO, réalisé par Distilled, très complet et puissant pour peu qu’on y passe un peu de temps…

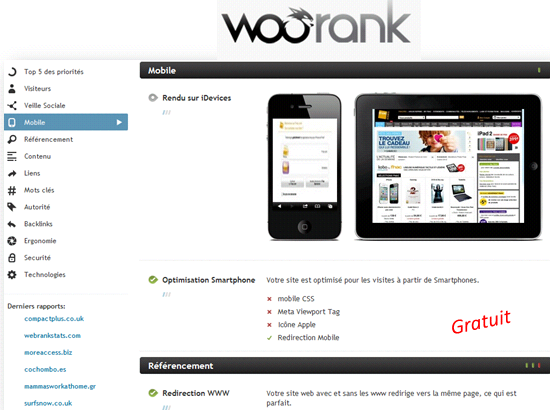

Woorank, pour faire un mini audit rapide sur un nom de domaine

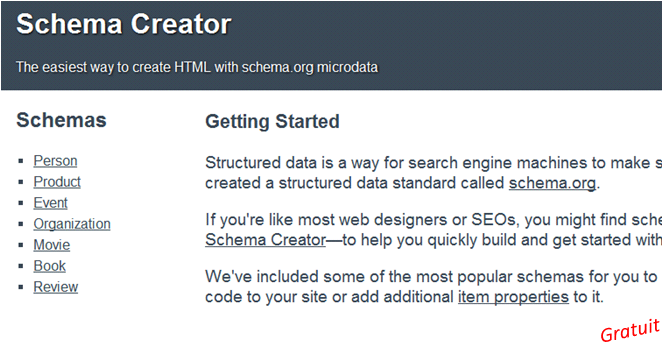

Schema Creator, pour simplifier la creation de microdata, car parfois on s’y perd sur schema.org

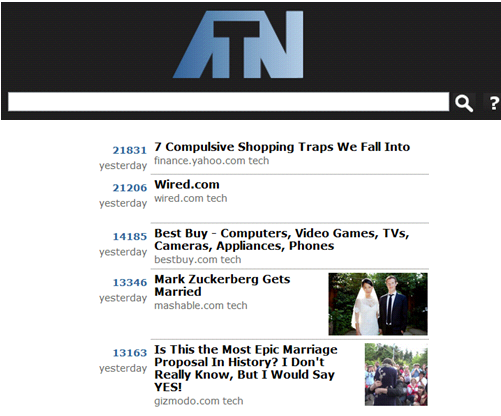

http://www.allthingsnow.com/ permet de trouver rapidement les sujets qui buzzent aujourd’hui sur le web

Outils linkbuilding

De très bons outils pour gérer ses campagnes de netlinking comment à arriver à maturité aux US.

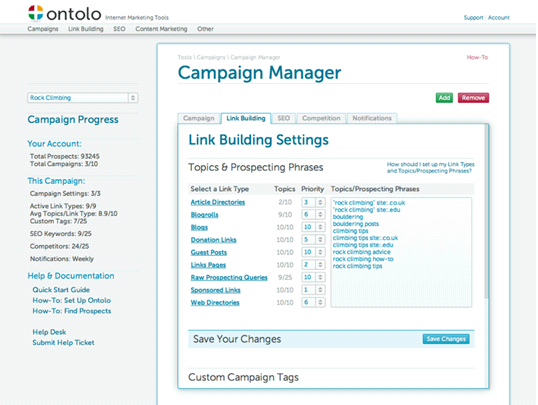

Ainsi, Ontolo.com propose une plateforme d’outils dédiés au link building. C’est un peu le scrapbox du white hat 🙂

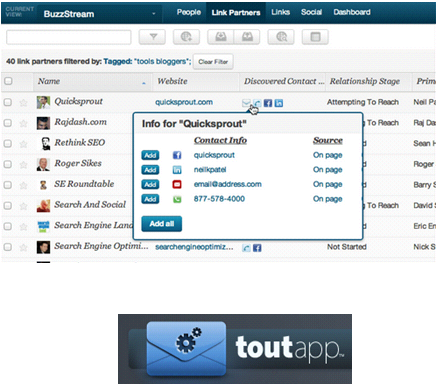

Buzzstream est un CRM très complet permettant de gérer ses campagnes d’acquisition de liens. Le suivi des contacts peut également se faire avec ToutApp : templating d’emails, etc.

La plateforme de ce type la plus aboutie est certainement Linkdex, même si les modules manquent parfois de puissance, le fait de pouvoir ajouter des task devant chaque information/KPI en fait un vrai outil de travail. Ces plateformes offrent des outils, mais cadrent aussi la méthodologie utilisée pour mettre en œuvre une stratégie SEO. C’est parfois un peu contraignant mais cela peut aussi faire gagner beaucoup de temps et d’efficacité.

Les outils sont une aide mais ne fonctionnent pas tout seul !

Plus ils sont génériques, plus il faut de l’expérience et de la méthode pour en retirer de la valeur ajoutée. Par exemple iMacro ou Google Refine ne servent à rien de particulier mais peuvent tout faire 🙂

Le nombre d’outils disponibles sur Internet est impressionnant !

S’il ne devait en rester que 3, ce serait selon moi :

- un outil de relevé de positions

- un crawler

- un outil d’analyse de backlinks

et s’il ne devait y en rester qu’un ?

- un développeur !

Relevé de positions / grab des resultats de Google

C’est le besoin numéro un des SEO

Chaque requête sur Google fourni un nombre considérable d’informations

- Titres, (rich)snippets, URLet position des sites

- Nb de résultats et liens Adwords

- Version en cache et « sites similaires »

- Présence et détail des éléments issus de la recherche universelle :

- News

- Images

- Vidéos

- Actu

- Map

- Shopping

- et désormais le Knowledge graph

- Google Suggest

- Recherches associés

- Suggestion de requêtes

- Etc.

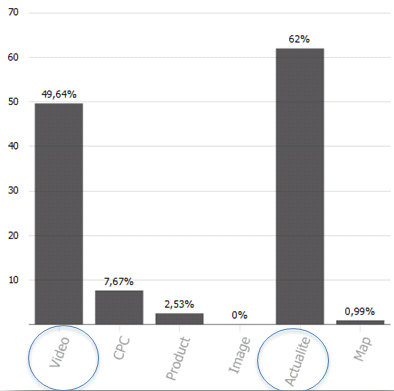

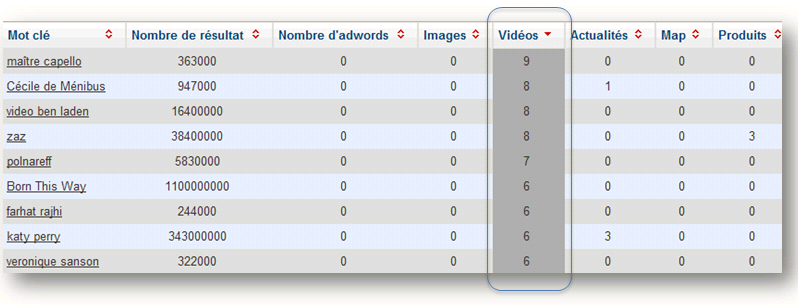

La plupart des outils de monitoring de positions commencent à intégrer les résultats issus de la recherche universelle. Si sur votre liste de mots clés vous avez un pourcentage important des requêtes qui déclenchent un de ces blocs, vous avez des actions à mettre en place. Exemple sur une liste de mots clés dédiés à l’actualité :

Avec 50% de mots clés qui déclenchent un bloc vidéo et 62% un bloc actu, il y a des choses à faire !

Actions à mettre en place pour optimiser votre visibilité sur les blocs vidéos de la recherche universelle :

- Produire des vidéos optimisées directement pour les mots clés qui déclenchent ces vidéos

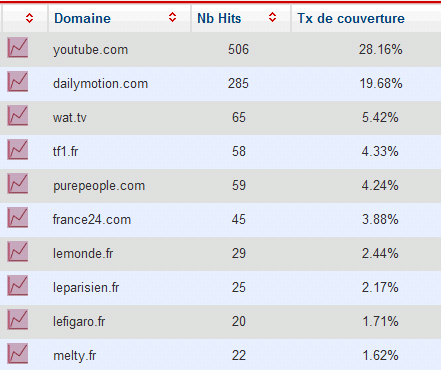

- Propager vos vidéos sur les sites qui ressortent déjà avec des vidéos sur vos mots clés

Actions à mettre en place pour optimiser votre visibilité sur les blocs actu de la recherche universelle :

- Contactez les sites qui remontent dans Google Actualité pour leur proposer un partenariat de « placement de contenus »

Détournez votre logiciel de suivi de position pour vérifier la bonne indexation de votre site dans Google :

- Fabriquez des échantillons d’URLs de votre site, découpés par template, rubrique ou niveau de profondeur dans l’arborescence

- Lancez ce type de requêtes avec votre logiciel :

site :www.votresite.com/rubrique/page1.html - Vous pourrez en sortir un ratio de pages non indexées / pages disponibles

- Cela vous aidera à prioriser vos prochaines actions SEO sur votre site : travailler en priorité le template ayant le ratio le plus faible

Identifier les sites qui émergent sur notre champ lexical cible afin :

- d’être le premier à mettre en place un partenariat

- parfois même de les racheter !

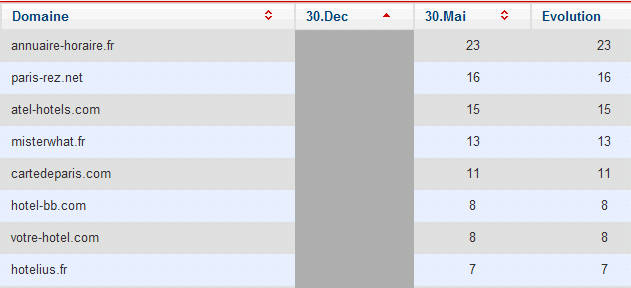

Exemple : les sites qui étaient invisibles en début d’année sur les noms d’hôtels parisien et qui se positionnent désormais sur cette thématique

Les crawlers

Là aussi, il existe un grand nombre d’outils disponibles sur le marché.

Certains sont payants, d’autres gratuits comme Xenu

L’analyse des résultats d’un crawl fait partie des choses les plus difficiles en SEO, si l’on souhaite aller au-delà des classiques balises dupliquées, pages 404, erreur 30x, etc.

Mais l’avantage de ces outils, est qu’ils permettent en général d’identifier un très grand nombre d’actions d’optimisation qui nécessitent parfois des travaux sur plusieurs années !

Rares sont les outils du marché qui permettent de mettre en parallèle des URLs crawlées, les logs Googlebot et les visites moteurs arrivant sur les URLs.

Il s’agit souvent d’outils développés par des agences pour des clients ayant un volume important de pages.

De même, peu d’outils grand public permettent de définir des catégories selon le format des URLs (SeeURank Falcon le fait)

Vérifiez également la prise en compte des nofollow, canonical, noindex… (par exemple Xenu n’en tient pas compte)

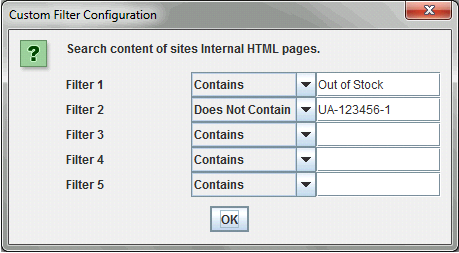

Screaming Frog, est certainement le crawler SEO grand public le plus avancé. Dans sa version payante (99£), il permet par exemple de réaliser des filtres personnalisés :

Il gère les canonical, peut suivre ou non le nofollow, etc.

Ne permet pas en revanche la catégorisation, les traitements doivent se faire sur Excel après export.

Analyse de backlinks

Les SEO n’ont toujours pas retrouvé d’outil ayant des données aussi fraîches et exhaustives que celles de feu Yahoo! Site Explorer pour le marché FR

Ce dernier n’était déjà pas parfait…

Les outils les plus fiables aujourd’hui sont

L’outil idéal combinerait l’exhaustivité en fusionnant les données de ces trois sources et la valeur ajoutée des rapports tels que ceux de Raventools

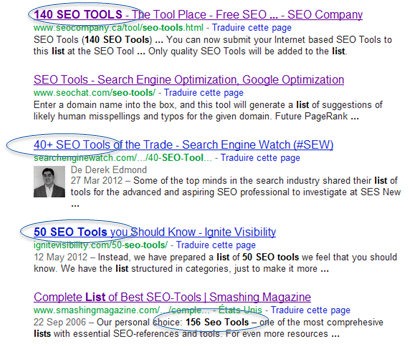

Exemples de techniques permettant de trouver des opportunités de netlinking grâce à ces outils :

- identifiez les sites depuis lesquels vos concurrents ont des liens et pas vous

- suivez chaque mois les nouveaux liens obtenus par la concurrence (technique du « pisteur »…)

- identifier les liens pointant vers des pages 404

– sur votre site

– sur les sites de vos concurrents

et contactez les sites émetteurs pour leur suggérer de mettre à jour leur lien

Et s’il n’en restait qu’un ?

Ce serait un développeur 🙂

En fonction des projets sur lesquels on travaille, et des besoins ponctuels que l’on peut avoir, il est régulièrement nécessaire de créer un script qui automatisera une tâche.

Chez RESONEO, nous avons développé une plateforme d’outils qui évolue selon les besoins. Les outils les plus génériques sont aussi ceux pour lesquels il faut avoir une forte expertise méthodologique pour pouvoir s’en servir efficacement.

Par exemple, un des premiers outils que nous avons créé chez RESONEO (en 2007) appliquait le process suivant :

- on entre un mot clé

- le script va extraire les 50 premiers résultats positionnés dans Google

- puis va extraire le contenu de ces 50 premières pages pour en faire une longue chaine de caractères

- il extrait ensuite les 1,2 et 3-grams de la chaine et présente le tout sous la forme d’un tag cloud

L’objectif étant de faciliter la recherche de mots clés à cibler, en s’inspirant des sites qui se positionnent mieux sur Google sur nos requêtes phares

En agence, nous avons besoin d’outils qui :

- soient utilisables par un Consultant SEO, geek, mais pas forcément développeur

- tiennent la charge sur de forts volumes de données traitées

Exemple d’outil générique que nous avons développé récemment et permettant d’extraire n’importe quelle information d’une liste d’URLs :

Bien sur, cette liste ne se veut pas exhaustive, si vous aussi vous connaissez des outils intéressants qui facilitent le travail et donnent lieu à des optimisations, n’hésitez pas à nous en parler dans les commentaires.